原文:场景导购系列一:个性化服饰搭配在淘宝搜索的实践 - 2018.02.05

出处:云栖社区

本文描述了使用深度学习算法在淘宝环境中怎么给用户提供个性化服饰搭配的一些探索.

1. 背景

日常生活中存在着各种各样的场景,比如参加晚会、海边度假、跑步、登山、垂钓等等.

场景可以认为是在一些维度上相似的元素所构成的情境画面,不同场景会有不同的氛围、组成元素.

一些场景偏实用性,比如跑步,会让人想起要穿上运动衣、运动裤等;垂钓,自然需要钓鱼竿、鱼饵. 用户淘宝平台上浏览、挑选一件商品时,往往会想到在特定场景下使用,比如买个油烟机,会想到在做饭时需要用到,同时也会想到做饭时还需些其它,比如锅、餐具等.

穿搭场景是一类重要的场景,这个场景要求有美感、时尚感,尤其对许多年轻、爱美的女性,她们在淘宝平台购物时,对自己的穿搭有较强的需求,往往需要能找到在不同场合下适合自己的搭配(outfit). 比如职场的白领女生,怎么穿搭才显得体;走在街上穿什么显得时尚;去海边度假又需要一套什么样的搭配等.

场景化的逛、购能使得用户身临其境,如果用户在平台购物时,我们能提供一些场景化的向导,应能丰富用户的体验. 下图是一些场景导购的例子:

图1 场景导购例子

淘宝平台上,服饰是很重要的一部分,服饰的穿搭也是场景导购重要的组成部分. 本文我们主要介绍穿搭场景. 我们抽象出具体场景知识,将重点放在穿搭本身,给用户提供个性化服饰搭配.

2. 业界现状

随着时尚产业、时尚杂志的快速发展,服饰时尚越来越受到关注. 时尚领域是计算机视觉的一个非常重要且利润丰厚的应用领域. 在该领域中已经存在许多研究,包括服饰检索与推荐[5,7,8,9,14,21]、服饰分类[3,11,15,18,22]、属性预测[1,2,4,23]、以及服饰时尚分析[14,16]等.

由于时尚概念的主观性,到目前为止,只有少量工作[10,13]研究时尚搭配. 基本的思路是,学习一个item的表示,再通过表示判断 outfit 中 item 之间的搭配程度.

有许多方法研究服饰的表示. Vittayakorn et al.[20]提取基本特征,并将它们连接在一起,形成一个向量用以表示outfit,Matzen et al.[16]使用深度学习方法训练多种属性分类器,再使用分类器的高层特征得到服饰的视觉表示,Simo-Serra et al.[18]训练一个分类器以提取不同的特征表示,同样也使用分类网络的高层特征作为时尚风格的表示.

在搭配构建方面,Veit et al.[19]使用Siamese Convolutional Neural Network (SCNN)学习得到每一个item的表示特征,再通过特征向量判断 item 之间是否相搭. Li et al.[13]使用基于深度学习的多模态(multi-modal)多实例(multi-instance) embedding 作为 outfit 的特征,质量分作为标签,以训练搭配打分模型.

在集团内,据我们了解,雷音老师团队对时尚搭配已有研究,并取得了不错的效果. 他们建设了一套搭配库,包括来自淘宝达人、搭配市场等的搭配套餐. 并以此为基础,算法上通过搭配部件可替换关系,扩展搭配的数量.

3. 相关调研

在学习调研搭配知识的相关文献(书籍、杂志等)以及业界相关工作的基础上,我们有了以下思考:

3.1. 搭配分类

有关于服饰搭配可以分为以下三类:

[1] - 服装与服装之间的搭配,比如上装与下装等;

[2] - 服饰与饰品的搭配;

[3] - 服装、饰品与人的搭配,主要涉及用户的年龄/职业/生活场景.

3.2. 搭配原则

服饰搭配会有以下几个基本原则:

[1] - 搭配的服饰要有品位,这表示组成搭配的单品要有美感;

[2] - 色彩重要性远大于款式和面料;

[3] - 视觉平衡能带给人更好的感觉,视觉平衡感指感觉上的大小、轻重、明暗以及质感的均衡状态;

[4] - 善用饰品,能增添光彩.

3.3. 搭配难点

搭配需要考虑的有许多,大致可以分为以下几点:

[1] - 不同的季节、月份,流行的单品不一样,时尚及流行趋势也所变化;

[2] - 搭配单品在外观上受到颜色、款式等的影响,在物理上受到材质、面料的影响;

[3] - 每个人的身材不一样,而且个性偏好各有不同;

[4] - 在电商场景下(搜索/推荐等),以什么样的产品形态,将搭配展现给用户.

3.4. 搭配数据

目前我们能够从时尚杂志、时尚网站等看到一整套搭配,或者是穿着在模特身上的时尚的搭配. 对于由达人编辑好的搭配(比如来自Polyvore.com等),我们能较容易的拿到搭配的各组成部分.

而对于穿在模特身上的搭配(比如淘宝模特的穿着等),我们需要首先将模特身上的衣服、裤子等提取出来,再做后续的处理.

3.5. 搭配技术

从算法上考虑,电商场景下,目前要一次性解决个性化搭配比较困难,首先没有足够的这方面数据,其次业界也基本没有这方面的经验可以借鉴. 不过对于单品与单品之间的搭配,如上所述,业界已给出了一些思路. 从图像角度看,我们比较容易识别出搭配单品的颜色、形状、纹理等,利用深度学习模型,从大量数据中学习搭配关系,这也是目前业界主要研究的方面.

3.6. 搭配方案

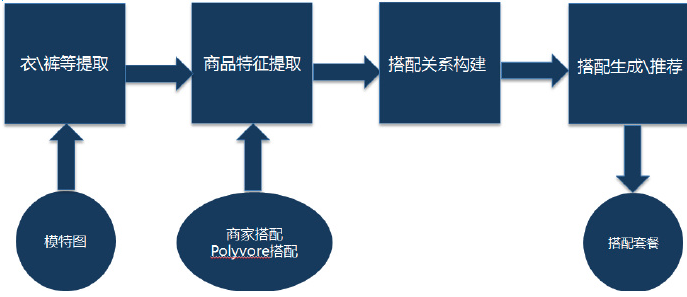

综合以上考虑,我们目前的工作主要 focus 在淘宝搜索场景下,分2步实现个性化搭配推荐:

[1] - 第一步,我们从图像上给出单品服饰之间的搭配关系;

[2] - 第二步,利用用户在全网行为(点击、加购、购买等)或者用户Profile、偏好,个性化生成搭配并推荐给用户.

方案主要有以下几方面:

[1] - 模特服饰提取:这部分简单介绍如何从商家模特图中,提取搭配数据,比如上衣、下衣等.

[2] - 搭配关系构建:这部分主要介绍如何从现有的搭配数据中,比如从商家模特身上提取的、达人推荐的、从时尚网站获取的,构建商品之间的搭配关系.

[3] - 个性化搭配生成推荐:这部分简单介绍我们在搜索中如何给用户推荐一套搭配.

整体如下图所示:

图2 方案简单流程图

4. 技术方案

4.1. 模特服饰提取

为了能获得更多优质的搭配数据,我们从商家模特中提取上衣、下衣等. 我们将该问题转化成 human parsing 的方式.

human parsing 是指将一幅人物图像(比如模特图等)分割成不同的部分,即将每个图像像素归为一类,比如上衣、下衣、头发、腿等. 它可以认为是语义分割(semantic segmentation)的一种具体应用,与语义分割相似,同时也有自己独特的地方,比如它需要考虑到人的姿势等.

下面先简单介绍近年来业界将深度学习应用于 human parsing 以及语义分割方面的基本工作,接着再给出我们的方案. (详细的工作见另外一篇文章)

4.1.1. 相关研究

基于深度学习的语义分割:

语义分割可被认为是种dense classification,因此,一些在图像分类中表现很好的卷积神经网络(Convolution Neural Network,CNN)结构,比如,VGG[25]、ResNet[26],通过轻微的改变,能达到语义分割的效果. 比如全卷积网络(Fully Convolutional Network ,FCN)[24] 通过将上述网络最后几层全连接层变为全卷积层,以实现语义分割. 该方法的分割结果比较粗糙(尤其在边缘),由于其feature maps的尺度在多次卷积后会显著下降. 为了避免该问题,Chen et al.[27]在deeplab中提出了dilated convolution,应用于语义分割. PSPNet[28]采用金字塔池化操作(pyramid pooling operation),以整合不同区域的context来获取全局的context信息. 还有些其它的结构,比如SegNet[29]、基于mask的结构[30]等,在语义分割中也得到了很好的效果.

基于深度学习的human parsing:

作为语义分割的一种具体应用,除了使用语义分割的一些方法,human parsing 还需要考虑自己独有的特点,比如在网络结构中加入额外的信息,以提升分割的精度. Liang et al.[31] 提出了Co-CNN结构, 该结构新增了交叉层内容、语义边缘信息等,这种方法使得网络相当复杂. Gong et al.[32] 提出了一种自监督结构敏感的学习方法用于human parsing,该方法需要特殊设计的数据集.

4.1.2. Finer-Net

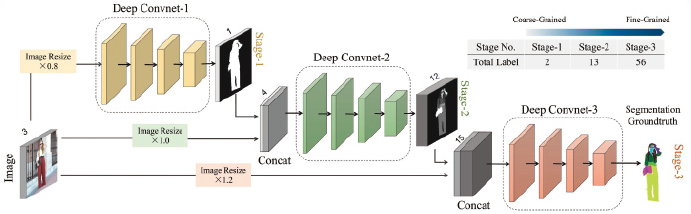

网络级联已经应用于许多计算机视觉的任务中,比如分类、姿态预估、检测等. 我们将该思想用于 human parsing中,提出了新的 human parsing框架,称为 Finer-Net.

下面简单介绍我们的 3 阶段 Finer-Net.

网络的第1阶段首先分割出前景人物区域,下一阶段将原始的输入图片以及上一阶段的结果作为输入,以得到每个像素更细粒度的标签(我们根据实际需要,控制输出的标签的数量).

此外,我们在网络结构中加入人物姿势特征,实验证明这带来了更好的分割结果.

具体网络架构如下图所示:

图3 Finer-Net框架. 第1阶段将人物图片分割成前后景,第2阶段将照片分割成更细的标签,比如衣服、裤子等,第3阶段输出更细的标签.

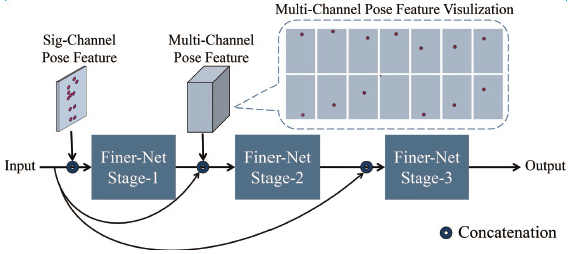

人物姿势影响着 human parsing 的结果,随着姿势的变化,一些细节可能不会被分割的很好,比如坐姿情况下的裤子. 如果加入一些先验的知识,这种情况应能在一定程度上得到解决,因此,我们在网络结构中加入了人体姿势信息,该信息是由 Convolutional Pose Machines[33] 得到的.

增加人体姿势信息的网络如下图所示:

图4 增加人体姿势的Finer-Net. 姿势信息被用于前2个阶段,每个阶段使用不同数量的 feature maps.

4.2. 搭配关系构建

这部分首先分析目前业界的搭配方案,再在此基础上,给出我们的方案.

4.2.1. 相关研究

如上所述,Veit et al.[19 ]使用SCNN学习得到每一个搭配单品的特征向量,并以此判断单品之间是否相搭. Li et al.[13] 使用基于深度学习的多模态多实例打分模型,提取outfit的特征向量,对一套搭配打分. 这些方法有个共同的特点,即提取的都是网络的高层特征,该特征混合了图片的多种信息(颜色、形状等),降低了可解释性. 然而,在实际应用中,对于设计者、用户而言,理解组成一套搭配的不同属性是很有必要的,比如该套搭配中单品的颜色是否相搭、款式是否相搭. 这就意味着,对于实际的搭配系统,我们需要一个可解释的模型. 可解释是指提取出的搭配单品的颜色特征仅仅表示颜色,形状特征仅仅表示形状等.

4.2.2. 搭配方案

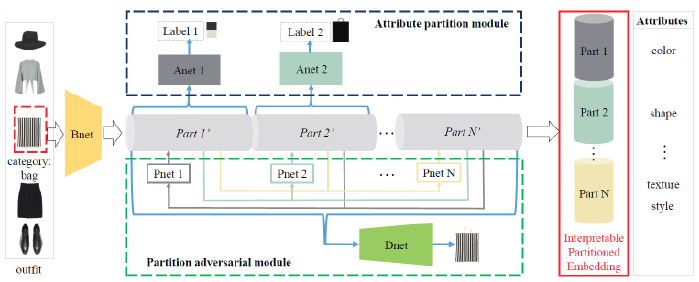

基于以上分析,我们提出了切分编码网络(partitioned embedding network),该网络有两个部分组成,属性切分模块(attribute partition module)以及切分对抗模块(partition adversarial module).

[1] - 在属性切分模块中,我们使用多属性标签,确保图片整体编码的不同部分表示不同的属性;

[2] - 在切分对抗模块中,我们使用对抗操作将不同的属性独立起来,这样同时也会提取出我们事先未定义的属性(比如纹理、风格等).

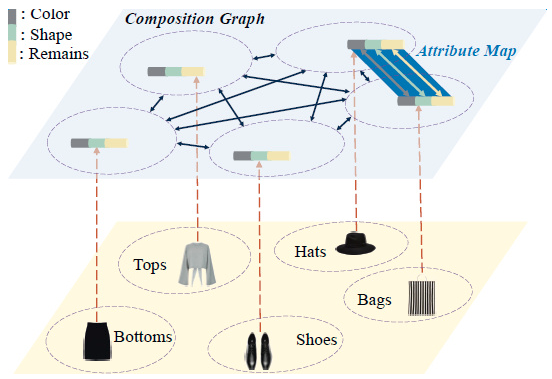

接下来,我们提出了 composition graph,使用提取出的切分编码(partitioned embeddings)构建outfit中的搭配关系. 下面进行详细介绍.

我们首先介绍切分编码网络,将图片整体编码切分成独立的不同部分,以表示不同的属性;

然后介绍如何使用 composition graph 构建搭配关系.

4.3.1. 切分编码网络

令 $I$ 表示一个搭配单品,$\mathcal{R} (I)$ 表示对单品的编码.

为了保证提取的编码可解释且可切分,需要满足以下2个条件:一方面,整体编码中固定的一部分应该对应具体的属性;另一方面,不同的部分是互相独立的.

因此,$\mathcal{R}(I)$ 可以表示为如下形式:

$$ \begin{array}{cc} \mathcal{R}(I) = [r_1; r_2; ..., r_N] \\ s.t. \mathcal{P}(r_i|r_j, j\neq i) = \mathcal{P}(r_i) \end{array} $$

其中,$r_i$ 是指不同的编码部分,$N$ 是指编码部分的总数. $\mathcal{P}(r_i|r_j, j\neq i) = \mathcal{P}(r_i)$ 表示 $r_i$ 独立于 $r_j, j\neq i$.

为了得到可解释、可切分的编码,我们提出了切分编码网络,如图5所示.

切分编码网络有两部分组成,属性切分模块以及切分对抗模块,以完成以上2个约束。

因此,切分编码网络的loss函数可定义如下:

$$ \mathcal{L} = \mathcal{L}_t(I, Label) + \alpha \mathcal{L}_a (I, \mathcal{R}(I)) $$

其中,$\alpha$ 为平衡参数,$\mathcal{L}_t(I, Label) = \frac{1}{N} \sum_{k=1}^N loss(I, Label_k)$表示平均每个属性的 loss. $\mathcal{L}_a (I, \mathcal{R}(I))$ 为切分对抗 loss.

图5 切分编码网络框架.

如图5, 网络有两个部分组成,属性切分模块以及切分对抗模块. 属性切分模块由属性网络 $Anet1$, $Anet2$ 组成,确保 $Part1′$, $Part2′$ 分别对应颜色和形状. 切分对抗模块包括对抗预测网络 $Pnet1$, $Pnet2$, ... ,$PnetN$ 以及解码网络$Dnet$,对抗预测网络确保整体编码不同部分相互独立,解码网络保证编码包含原始单品的所有有用信息.

4.3.2. 属性切分模块

有许多属性[20,15,16]描述时尚,比如颜色、形状、纹理、风格等. 某些属性明确定义较困难(比如纹理、风格),我们将它们统一分为其它属性. 因此属性被分为3大类,颜色、形状以及其它属性(纹理、风格等).

如图 5 中,$Bnet$ 用于提取单品的初始编码,然后属性网络 $Anet1$, $Anet2$ 确保整体编码的 $Part1′$, $Part2′$分别对应颜色属性以及形状属性.

在一套搭配中,颜色是首要考虑的属性,我们使用颜色主题提取方法[6]提取搭配单品前景区域的颜色主题作为颜色标签. 使用变分自动编码(Variational Auto-Encoder)模型[12]编码以及解码形状信息.

4.3.3. 切分对抗模块

经过属性切分模块,$Part1′$ 和 $Part2′$ 分别表示颜色以及形状信息,然而它们之间还会混合各自的信息,其它属性(比如纹理等)也不能找到明确对应的编码部分.

为了解决该问题(解耦各编码部分信息),我们引入了切分对抗模块.

切分对抗模块包含对抗预测网络以及解码网络. 解码网络保证编码包含原始单品的所有有用信息,对抗预测网络$Pnet1$, $Pnet2$, ... ,$PnetN$ 确保整体编码不同部分相互独立.

在以上2个网络的作用下,整体编码的剩余部分只包含其它属性信息. 因此,切分对抗loss $\mathcal{L}_a (I, \mathcal{R}(I))$ 可以表示为:

$$ \mathcal{L}_a (I, \mathcal{R}(I)) = \mathcal{L}_c(I, I') + \beta \mathcal{L}_d(r_1, r_2,...,r_N) $$

其中,$\beta$ 为平衡参数,$I'$ 为 $I$ 的解码图像,$\mathcal{L}_c(I, I')$ 表示解码loss, $\mathcal{L}_d(r_1, r_2, ..., r_n)$ 互相独立loss.

我们使用对抗操作[17]以达到相互独立性,因此,互相独立loss $\mathcal{L}_d(r_1, r_2, ..., r_N)$ 包含预测loss $\mathcal{L}_p $以及编码loss $L_e$. 在预测阶段,每个预测网络 $Pnet_i$ 尽可能最大化相应部分 $r_i$ 的可预测性,预测loss $L_p$ 表示如下:

$$ \mathcal{L}_p = \sum_{i=1}^N E[r_i - \mathcal{F}_{\theta(i)}(r_1, ..., r_{i-1}, r_{i+1}, ..., r_N)] $$

其中,$\mathcal{F}$ 为预测网络 $Pnet$, $\theta (i)$ 为网络参数.

在编码阶段, 编码网络 $Bnet_i$ 尽可能的让预测网络预测失败,即最小化可预测性. 编码loss表示如下:

$$ \mathcal{L}_e = -\sum_{i=1}^N E[r_i -\mathcal{F}_{\theta(i)}(r_1, ..., r_{i-1}, r_{i+1}, ..., r_N)] $$

因此,如果编码器能赢,就解耦了编码的各部分,即通过最小化可预测性,各编码部分能得到解耦.

4.3.4. Composition Graph

我们使用composition graph构建搭配关系,对于每个类目(每个单品对应一个类目),我们首先根据颜色编码,将所有单品聚成$N_p$ 个类中心;接着对每一类,根据形状编码,将属于该类的单品聚成 $N_q$ 个类中心;最后对每一类,使用剩余编码聚类得到 $N_r$ 个类中心. 因此,可以得到 $\mathcal{N} = N_p N_q N_r$ 个聚类中心. 这样以后,$\mathcal{G}$ 可表示如下:

$$ \mathcal{G} = (\mathcal{V}, \varepsilon, \mathcal{W}) $$

其中,$\mathcal{V}$ 为所有聚类中心的向量集合,$\varepsilon$ 和 $\mathcal{W}$ 分别表示边和权重的集合.

刚开始,所有向量 $v \in \mathcal{V}$ 之间没有连接,权重初始化为0. 如果单品 $I \in v_i$ 和单品 $I′ \in v_j$ 出现在同一搭配套餐中,且 $v_i$ 与 $v_j$ 之间没有连接,那么在它们之间就创建一个连接,同时将$w_{i,j}$ 设为1;如果 $v_i$ 与$v_j$之间的连接已经存在,那么$w_{i,j}$ 按照如下更新:

$$ w_{i,j} = w'_{i,j} + \alpha $$

其中,$w'_{i,j}$ 表示上一次权重.

图 6 展示了连接过程.

图6 Composition Graph

当 Composition Graph 构建完成后,对于一件单品,我们可以从 composition graph 中得到对应该单品的搭配. 我们通过每个类目能够召回的单品数控制生成套餐的时间复杂度.

4.3. 个性化搭配生成推荐

这部分我们简单介绍下在搜索场景下,如何给用户推荐搭配.

基本流程是:当用户输入query(比如大衣),我们会根据用户的行为数据,得出用户的偏好类目(比如牛仔裤、毛衣),再在各自类目下选取top N 的商品,接着我们使用如上所述的Composition Graph,以用户输入query类目下的商品作为主商品,构建用户偏好类目下商品之间的搭配关系,生成搭配套餐,并推荐给用户.

5. 实验及线上效果

5.1. 数据集

实验中的数据主要来源于3部分:

[1] - 一部分如上所述,从商家模特图中提取出上衣、下衣等,组成搭配套餐;

[2] - 另一部分是商家、达人提供的已搭配好的数据;

[3] - 还有一部分来源于 Polyvore.com,该网站是一个以时尚为导向的网站,每天有成千上万的搭配在该网站创建. 每个搭配都有点赞数以及搭配商品. 我们对原始数据进行了简单的处理,比如选取高点赞数的搭配等,以得到相应的搭配套餐.

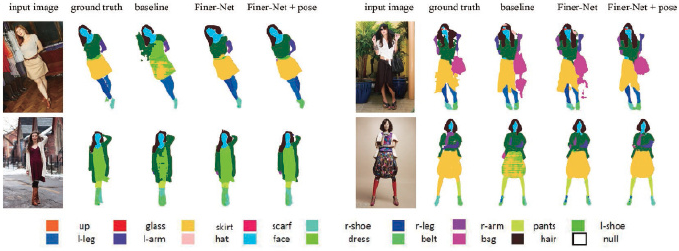

5.2. Human parsing效果

我们在标准数据集(ATR)[31]、以及淘宝数据上测试分割效果,分别如下图所示:

标准数据集:

图7 ATR数据集分割结果. 分别是原始图片、groundtruth、FCN分割结果、Finer-Net 分割结果以及加入姿势信息的Finer-Net分割结果.

淘宝数据集:

图8 淘宝数据集分割结果

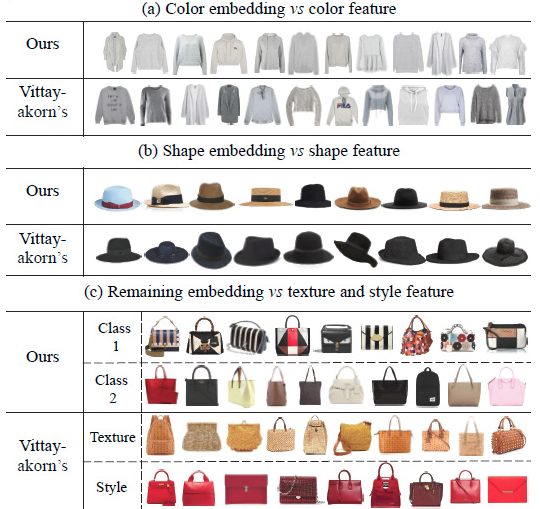

5.3. 切分编码有效性验证

我们使用聚类方法验证我们属性编码的区分能力,并将其与手工属性特征[20]作比较.

图9是部分结果.

图9(a)表示相比手工特征,我们的颜色编码有更多相似的颜色在一起.

图9(b)表示我们的形状编码的聚类结果,有相似的形状以及不同的颜色.

图9(c)中,可以看到,我们的聚类结果有着相似的纹理,不同的颜色以及形状.

实验表明,手工提取的特征通常混合其它属性信息,而我们模型的不同编码部分能表示各自的属性信息.

图9 切分编码有效性验证

5.4. 层次聚类效果

我们将提取的切分编码(颜色、形状及其它)按照如上所述的方式聚类,图10是部分结果.

图10 层次聚类结果,每一行表示一类.

5.5. 搭配套餐生成结果

我们按照如上所述方式,生成搭配套餐,部分结果如图11所示.

图11 搭配套餐结果

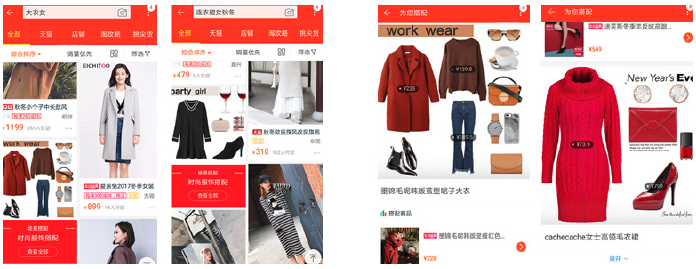

5.6. 线上效果

我们将生成的搭配套餐上线至主题搜二跳页,并在淘宝主搜结果页透出. 部分结果见下图:

图12 线上效果. 左边为搜索结果页结果,右边为搭配页结果.

6. 总结与计划

我们结合搜索、图像、个性化,将搭配应用到淘宝搜索中,期望丰富用户在搜索场景下的体验,只是一次初步的尝试,还有很多方面需要进一步探索. 比如丰富搭配的场景,搭配关系构建引入知识图谱等.

7. 参考文献

[1] K. Abe, T. Suzuki, S. Ueta, A. Nakamura, Y. Satoh, and H. Kataoka. Changing fashion cultures. arXiv preprint arX-iv:1703.07920, 2017.

[2] L. Bossard, M. Dantone, C. Leistner, C. Wengert, T. Quack,and L. Van Gool. Apparel classification with style. In Asian conference on computer vision, pages 321–335. Springer,2012.

[3] H. Chen, A. Gallagher, and B. Girod. Describing clothing by semantic attributes. Computer Vision–ECCV 2012, pages 609–623, 2012.

[4] Q. Chen, J. Huang, R. Feris, L. M. Brown, J. Dong, and S. Yan. Deep domain adaptation for describing people based on fine-grained clothing attributes. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 5315–5324, 2015.

[5] W. Di, C.Wah, A. Bhardwaj, R. Piramuthu, and N. Sundaresan. Style finder: Fine-grained clothing style detection and retrieval. In Proceedings of the IEEE Conference on computer vision and pattern recognition workshops, pages 8–13,2013.

[6] Z. Feng, W. Yuan, C. Fu, J. Lei, and M. Song. Finding intrinsic color themes in images with human visual perception.Neurocomputing, 2017.

[7] J. Fu, J. Wang, Z. Li, M. Xu, and H. Lu. Efficient clothing retrieval with semantic-preserving visual phrases. In Asian Conference on Computer Vision, pages 420–431. Springer, 2012.

[8] M. Hadi Kiapour, X. Han, S. Lazebnik, A. C. Berg, and T. L.Berg. Where to buy it: Matching street clothing photos in online shops. In Proceedings of the IEEE International Conference on Computer Vision, pages 3343–3351, 2015.

[9] J. Huang, R. S. Feris, Q. Chen, and S. Yan. Cross-domain image retrieval with a dual attribute-aware ranking network. In Proceedings of the IEEE International Conference on Computer Vision, pages 1062–1070, 2015.

[10] T. Iwata, S. Wanatabe, and H. Sawada. Fashion coordinates recommender system using photographs from fashion magazines. In IJCAI, volume 22, page 2262, 2011.

[11] M. H. Kiapour, K. Yamaguchi, A. C. Berg, and T. L. Berg. Hipster wars: Discovering elements of fashion styles. In European conference on computer vision, pages 472–488. Springer, 2014.

[12] D. P. Kingma and M. Welling. Auto-encoding variational bayes. stat, 1050:1, 2014.

[13] Y. Li, L. Cao, J. Zhu, and J. Luo. Mining fashion outfit composition using an end-to-end deep learning approach on setdata. IEEE Transactions on Multimedia, 2017.

[14] Q. Liu, S. Wu, and L. Wang. Deepstyle: Learning user preferences for visual recommendation. In Proceedings of the 40th International ACM SIGIR Conference on Research and Development in Information Retrieval, pages 841–844. ACM, 2017.

[15] Z. Liu, P. Luo, S. Qiu, X. Wang, and X. Tang. Deepfashion: Powering robust clothes recognition and retrieval with rich annotations. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 1096–1104, 2016.

[16] K. Matzen, K. Bala, and N. Snavely. Streetstyle: Exploring world-wide clothing styles from millions of photos. arXiv preprint arXiv:1706.01869, 2017.

[17] J. Schmidhuber. Learning factorial codes by predictability minimization. Learning, 4(6), 2008.

[18] E. Simo-Serra and H. Ishikawa. Fashion style in 128 floats:Joint ranking and classification using weak data for feature extraction. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 298–307, 2016.

[19] A. Veit, B. Kovacs, S. Bell, J. McAuley, K. Bala, and S. Belongie. Learning visual clothing style with heterogeneous dyadic co-occurrences. In Proceedings of the IEEE International Conference on Computer Vision, pages 4642–4650, 2015.

[20] S. Vittayakorn, K. Yamaguchi, A. C. Berg, and T. L. Berg.Runway to realway: Visual analysis of fashion. In Applications of Computer Vision (WACV), 2015 IEEE Winter Conference on, pages 951–958. IEEE, 2015.

[21] X. Wang and T. Zhang. Clothes search in consumer photos via color matching and attribute learning. In Proceedings of the 19th ACM international conference on Multimedia,pages 1353–1356. ACM, 2011.

[22] K. Yamaguchi, M. H. Kiapour, L. E. Ortiz, and T. L. Berg. Parsing clothing in fashion photographs. In Computer Vision and Pattern Recognition (CVPR), 2012 IEEE Conference on,pages 3570–3577. IEEE, 2012.

[23] K. Yamaguchi, T. Okatani, K. Sudo, K. Murasaki, and Y. Taniguchi. Mix and match: Joint model for clothing and attribute recognition. In BMVC, pages 51–1, 2015.

[24] J. Long, E. Shelhamer, and T. Darrell, “Fully convolutional networks for semantic segmentation,” in CVPR, 2015.

[25] K. Simonyan and A. Zisserman, “Very deep convolutional networks for large-scale image recognition,” in ICLR, 2015.

[26] K. He, X. Zhang, S. Ren, and J. Sun, “Identity mappings in deep residual networks,” in ECCV, 2016.

[27] L. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Yuille, “Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs,” TPAMI,2017.

[28] H. Zhao, J. Shi, X. Qi, X. Wang, and J. Jia, “Pyramid scene parsing network,” in CVPR, 2017.

[29] H. Noh, S. Hong, and B. Han, “Learning deconvolution network for semantic segmentation,” in ICCV, 2015.

[30] P. O. Pinheiro, R. Collobert, and P. Doll′ar, “Learning to segment object candidates,” in NIPS,2015.

[31] X. Liang, C. Xu, X. Shen, J. Yang, J. Tang, L. Lin, and S. Yan, “Human parsing with contextualized convolutional neural network,” TPAMI, 2017.

[32] K. Gong, X. Liang, X. Shen, and L. Lin, “Look into person: Self-supervised structure-sensitive learning and a new benchmark for human parsing,” in CVPR, 2017.

[33] S. Wei, V. Ramakrishna, T. Kanade, and Y. Sheikh,“Convolutional pose machines,” in CVPR,2016.

致谢

感谢所有帮助的同学、老大的支持和帮助(仁重,青峰)

产品和运营:松雨,芈月

前端:宏芃,麒飞

鲁班:昭明

团队影生、宇淮、致程等,跟他们学习讨论的过程中,收获很多.

感谢技术发展部的同学,帮我们达成了和浙大宋老师的合作完成人:苏哲,仁重,范数,可邑,深言