原文:AI帮你抠图,阿里妈妈自研算法入选国际顶级学术会议

作者:InfoQ

转载记录备忘.

用户上传一张图片,AI 就能“猜”到你的需求,自动高精度抠图,包括头发丝、婚纱、烟雾等半透明区域. 这是继在戛纳名声大噪的阿里妈妈 AI 智能文案之后,阿里妈妈算法团队在 AI 领域的又一新进展——用人工智能帮助设计师实现全自动抠图.

这一自动人物抠图算法(Semantic Human Matting)为阿里妈妈自研算法,目前已经被多媒体领域国际顶级学术会议(CCFA类会议)ACM MultiMedia 2018 接收.

阿里妈妈也开发了以这一算法为核心的工具,便于商家和设计师自动化抠图. 据悉,AI 智能抠图也是阿里妈妈 Ad Tech布局中的一环,随着它在人工智能领域探索的逐渐深入,用数据技术赋能商家营销的特色会越来越明显,尤其体现在内容营销的创新当中.

全自动抠图,阿里妈妈自研算法获国际认可

用机器辅助抠图,这种半自动的方式在行业里并不鲜见,但同样需要操作者具备一定经验,并反复调整,尤其是对头发丝、婚纱、玻璃瓶、烟雾等对抠图精细程度高的类别,还是设计师手工操作,需要耗费大量的精力.

对此,阿里妈妈开创了一种全自动的人物抠图方法。凭借其自研的自动人物抠图算法(Semantic Human Matting),能够将目标对象从图片中精确地提取出来.

为了实现这种高质量的自动化抠图效果,阿里妈妈算法团队在数据集和算法上都做了大量的工作,数据集的规模远远超过了目前公开的人物抠图数据集,同时,用自研算法保证抠图对象的完整性和局部细节的精确度.

体现在工具上,自动化的特点十分明显,设计师不需要专门的抠图培训,只需上传图片就可以将目标从图片中高精度地提取出来,如果不满意,再稍动几笔便可以实现调整.

阿里妈妈技术实力输出,Ad Tech 趋势明显

在不断打磨算法的同时,阿里妈妈也将这种自动人物抠图的能力落实到产品和工具上,为商家实际的营销痛点提供解决方案.

对于阿里巴巴这样的大型电商平台而言,无论是店铺内容的商品展示,还是用于广告投放的创意,图片都是重要的载体,以人物为代表的精细抠图成为了商家运营过程中绕不开的一环和痛点.

如同 AI 智能文案一样,阿里妈妈 AI 智能抠图也是为了解决商家的营销痛点,一方面将设计师从复杂耗时的抠图流程中解放出来,同时极大赋能设计领域.

这得益于阿里巴巴庞大而真实的营销场景,阿里妈妈算法团队可以将这些场景中的痛点作为课题,寻求技术解决的路径,并将解决方案应用于实际的场景.

因此,阿里妈妈通过技术驱动营销的特色已经十分明显,尤其是在人工智能领域,通过一系列智能解决方案的输出,Ad Tech 成为每一个商家都能感知和受益的基础设施.

为了帮助读者进一步理解阿里妈妈的自动抠图技术,后文将会以论文的形式展现,该论文内容来源于阿里妈妈(等待加入一部分论文撰写团队的介绍).

阿里妈妈算法平台致力于推动广告创意产业的AI升级,努力打造创意制作、理解和投放的全栈智能化. 得益于阿里巴巴庞大而真实的营销场景,团队在智能写作、图像技术、视频技术等领域持续发力和创新,已构建出AI智能文案、实时个性化创意等特色技术,用AI赋能现代营销,驱动产业升级.

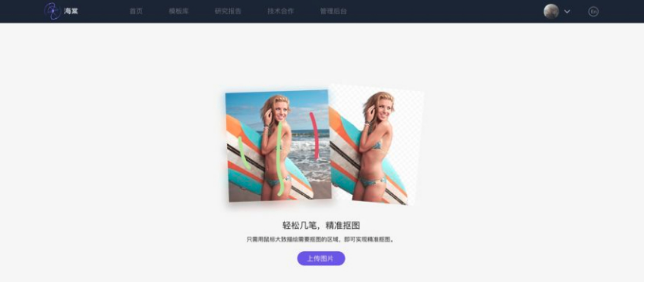

阿里妈妈智能抠图编辑器

阿里妈妈智能抠图编辑器旨在为设计领域提供简单、易用的在线抠图工具. 用户只需要寥寥几笔甚至不需要任何操作即可以将目标从图片中高精度提取出来,包括头发丝、婚纱、玻璃瓶、烟雾等半透明区域. 该工具中使用的自动人物抠图算法(Semantic Human Matting)为阿里妈妈自研算法,目前已经被多媒体领域国际顶级学术会议ACM MultiMedia 2018 接收.

arXiv 版本地址:http://arxiv.org/abs/1809.01354

背景

抠图是一项从图片中将目标前景高精度提取出来的图像处理技术,其被广泛应用在图像编辑、混合现实、创意合成和电影制作工业中. 在像阿里巴巴这种大型电商平台中,无论是店铺内部的商品展示,还是用于广告投放的创意,图片都是重要的载体. 而精美创意图片的制作,掌握复杂且耗时的精细抠图方法,往往是设计师绕不开的问题,相信设计领域的同学经常使用PhotoShop(PS)来抠图,对这一点应该深有体会.

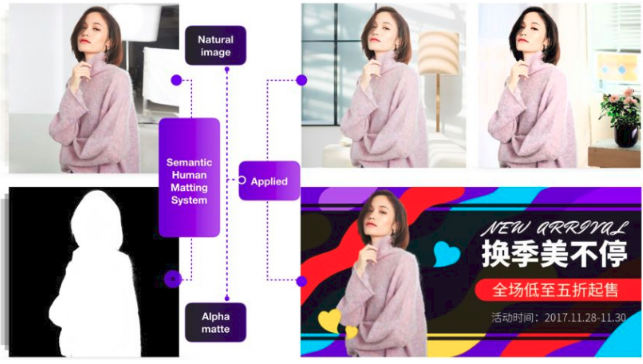

如果有一个工具,设计师不需要专门的抠图培训,只需寥寥几笔,甚至不需要任何操作即可以将目标从图片中高精度提取出来,还能处理包括头发丝、婚纱、玻璃瓶、烟雾等这种半透明区域,将设计师从复杂耗时的抠图流程中解放出来,专注在设计本身,应该能极大赋能设计领域. 而这正是阿里妈妈智能抠图编辑器期望解决的问题,其中图 1 即为机器自动抠图,然后应用在创意图片制作的例子:

图1 机器自动抠图在创意图片制作中的应用 [1]

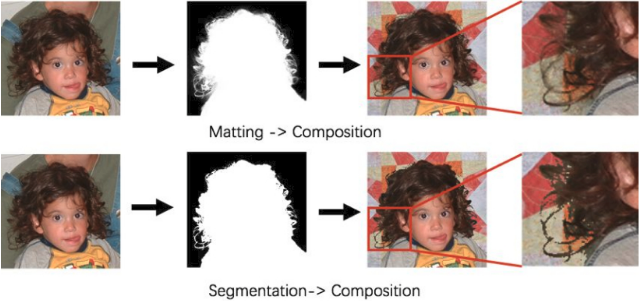

提起抠图,大家肯定会联想到计算机视觉中的一个经典任务:图像分割(Image Segmentation),特别是随着深度学习(Deep Learning)的兴起,图像分割任务受到越来越多的研究者和公司的重视和投入,不断有大型数据集被发布,分割类别也从两类分割(Binary Segmentation)到几十类分割,甚至几千类的分割,分割任务也从语义分割(Semantic Segmentation)进化到了实例分割(Instance Segmentation),分割效果也达到了前所未有的精度. 大家也就很自然想到使用图像分割作为抠图背后的算法,但我们认为即使目前公开的最优秀的分割模型结构(如 Mask-RCNN 等)在目前公开的最大型的分割数据集(如 COCO 等)上训练得到的结果也很难满足图像编辑这种高精度的,带半透明度的严苛要求. 这其中的原因包括数据集制作的方法(Segmentation 的数据集的 Label 为二值化的 Mask),模型结构设计的等因素. 图 2 展示了 Matting 和 Segmentation 得到的抠图结果在图片合成中的不同效果. 可以看到 Segmentation 的结果比较“硬”,合成图片中有比较明显的 PS 痕迹.

图 2 Matting 和 Segmentation 的不同抠图效果在图片合成中的不同效果,图片来源于 [2]

在学术领域,抠图一般叫 Image Matting,其可以被形式化为如下数学问题:

其中,

Trimap,即图 3 中的图(b),一般通过用户交互得到,它将图像划分为 3 个区域,分别为确定前景(Definite Foreground),确定背景(Definite Background)和不确定区域(Unknown),这样通过从用户中得到的 Trimap 作为约束,极大的提高了抠图效果. 目前学术界中的绝大多数抠图方法都采用了这一思路,但 Trimap 一般需要用户提供,画 Trimap 也是一个较耗时和需要“技术”的事情. 因此,我们希望完全不需要人工交互,或者只需要较少的人工交互,即可提供不错的抠图结果. 基于这个思路,我们提出了全自动的人物抠图算法和制作了带有少量人工交互功能的任意物体在线抠图编辑器.

图 3 学术领域中 Image Matting 基本概念介绍,图片来源于 [3]

自动人物抠图

服装类目作为淘宝天猫的重要类目,其中的商品展示图片包含了大量模特,为模特或者人物制作专门的自动抠图算法具有重要应用价值. 基于这个应用出发点,我们研发了自动人物抠图算法,该算法已沉淀为论文 Semantic Human Matting (SHM) [1] 并已经被 ACM MultiMedia 2018 接收,arXiv 版本地址为:https://arxiv.org/abs/1809.01354. 下面简单介绍我们为处理该问题所做的思考和工作.

A1. Pipline

设计一种全自动的人物抠图方法并不是一件容易的事情. 如上文所介绍,人们很容易想到直接借助目前计算机视觉领域 Semantic Segmentation 或者 Image Matting 技术来解决,但我们认为直接应用他们中的任何一种方法都很难拿到令人满意的效果.

我们首先来考察 Semantic Segmentation,目前的 Semantic Segmentation 模型通常聚焦在相对来说比较粗糙的语义信息判别,而常常容易模糊掉结构化的细节,如头发丝,网状区域等,也不能预估如婚纱这种典型的半透明度区域的半透明度.

然后我们来考察具有提取半透明区域能力的 Image Matting 方法,如前诉述,这种方法往往需要用户给定的 Trimap 作为约束,这种需要用户参与的方式,就自然阻碍了全自动的过程.

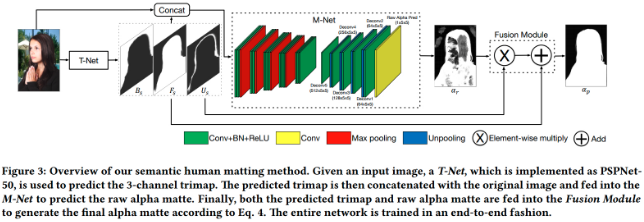

因此在这篇论文中,我们将 Semantic Segmentation 模块集成到了一个基于深度学习的 Matting 模块中,来实现人物的自动抠图. 我们将 Semantic Segmentation 模块学习到的前背景语义信息注入到 Deep Matting 模块中来完成在提取结构化细节信息和半透明信息的同时,保证语义的完整性. 其网络完整结构如下图所示.

图 4 Semantic Human Matting Network Architecture [1]

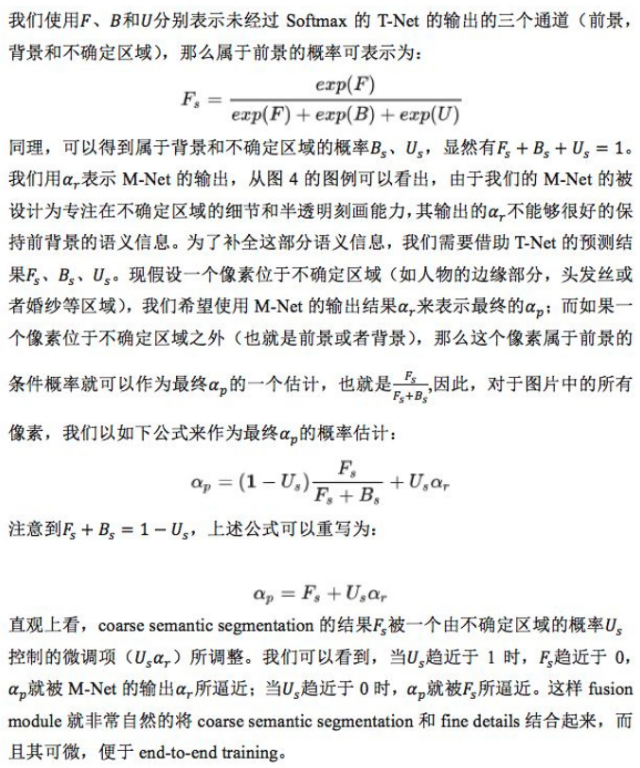

该网络包含三个模块,负责 Trimap 预测的语义分割模块 T-Net,负责半透明度等细节预估的 M-Net 和负责融合语义信息和细节信息的 Fusion Module.为了保证整个网络可以 end-to-end 的训练,以便能够统一优化,得到更好的解,我们提出了一种简单但有效的融合策略,它能够自然的给出 alpha 的概率估计,从而让 T-Net 和 M-Net 自适应的协作,达到在保证语义完整性的同时兼顾半透明等细节.

在这个工作中,我们的主要贡献为:

- 我们所知,SHM 是第一个完全使用深度学习网络来同时学习高级语义信息和低级视觉细节信息的自动人物抠图算法. 并且经验结果显示,SHM 算法能够取得与 state-of-the-art 的交互式抠图算法(非全自动,需要用户参与提供 trimap)相媲美的效果.

- 我们提出了一个简单但实用的可微自动融合模块. 它能够自动的在每个像素级别上同时考虑粗糙的高级语义信息和精细的低级视觉细节信息,并且让两个子网络协作来完成 end-to-end 的学习,这对于我们的效果保证非常重要.

- 为了训练这个网络,我们构造了一个包含 52,511 张训练图片和 1,400 张测试图片的大型人物抠图数据集,据我们所知,这是目前最大的 Matting 领域的数据集.

下面我们主要简单介绍一下 Fusion Module、Training Loss 和部分实验结果.

A2. Fusion Module

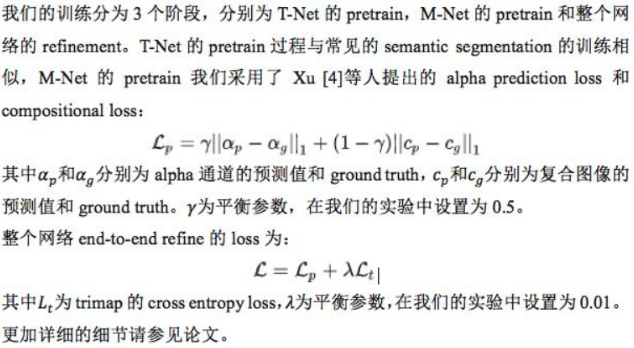

A3. Training Loss

A4. Experiments

A4.1. 客观指标

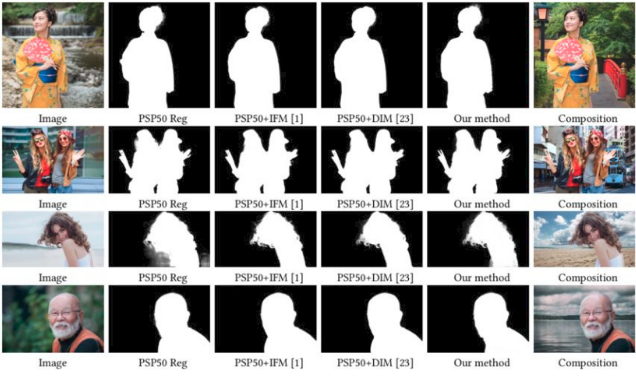

为了训练整个网络,我们构建了目前已知最大的 Matting 数据集,包含 52,511 张训练图片和 1,400 张测试图片. 我们采用了 Matting 领域常用的评测指标 SAD, MSE, Gradient Error 和 Connectivity Error 作为客观评价标准 [5],并结合 state of the art 的 segmentation 网络和 Matting 方法建立基线. 具体指标结果如下:

除此之外,我们对我们网络中的各个组成成分进行了 Ablation 实验,验证各个模块的作用.

可以发现我们方法在各个指标上相比于基线均有明显提高.

我们同时对比了目前 state-of-the-art 的交互式抠图方法(需要人工提供 trimap)与我们方法的效果,如下表所示:

可以发现,我们的自动抠图方法比绝大多数需要提供 trimap 的交互式抠图方法效果都好,需要注意的是,上表中别的方法都需要人工提供精确的 trimap,而我们的方法除了输入图片之外,不需要提供任何额外信息. 虽然我们的方法比 Trimap+DIM 这种交互式抠图方法在客观指标上要差一点,但在从下节中主观视觉对比中可见,其在视觉上与该种方法差别不太大.

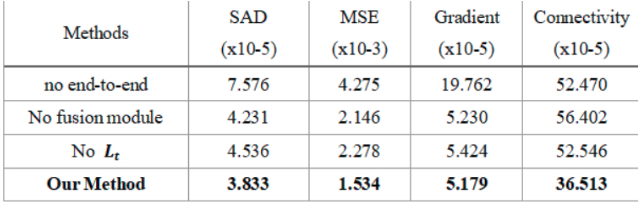

A4.2. 主观视觉对比

我们展示了我们方法与其中几种典型方法的视觉对比,以下为论文截图,更多方法和高清的图片对比请参考论文和补充材料 [1].

图 5 主观视觉可视化对比

图 6 主观视觉可视化对比

A4.3. 中间结果可视化分析

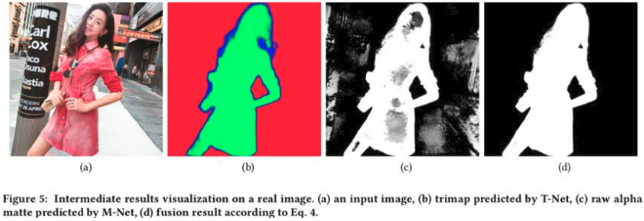

为了更好的理解我们的 SHM 的工作机制,查看两个子网络是如何协作的,我们对该网络的中间结果进行了可视化,如图 7 所示:

图 7 中间结果可视化对比

其中(a)为输入图片,(b)为 T-Net 预测的前景(绿色),背景(红色)和不确定区域(蓝色)的概率值显示在 RGB 图像上,(c)为 M-Net 的输出结果,(d)为经过 fusion module 之后的最终 alpha 的预测值.

从中我们可以看到,T-Net 能够自动的分割出人物的主体部分,并且能够区分出人物轮廓部分划分为不确定区域时哪些地方应该给予较窄的边,哪些结构性细节应该给予较宽的边. 并且,由于有 T-Net 负责主体语义部分,这让 M-Net 可以更加专注在细节等半透明区域,然后通过 fusion module 的融合,使我们能够得到高质量的 alpha 预估结果,而这正符合我们的设计初衷.

交互式抠图编辑器

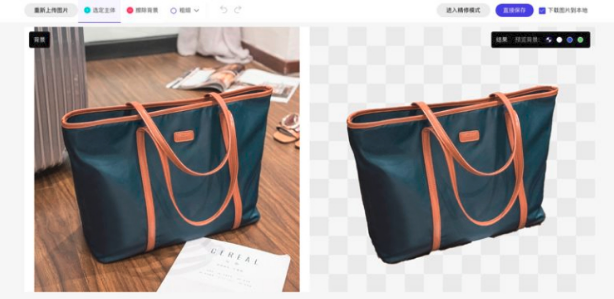

在自动人物抠图算法的基础上,通过与 UED 团队,前端团队和算法工程团队合作,我们开发了通用物体的在线抠图工具. 用户只需要简单几笔甚至不需要任何操作即可以将目标从图片中高精度提取出来. 该工具的主要目标就是最大程度简化抠图流程甚至完全自动化. 下面将简要介绍在线交互式抠图编辑器的主要流程和使用方法.

抠图流程示例

以下我们演示一个能够用到我们整个流程的抠图案例,需要注意的是,并不是每张图片都需要走完全部流程,如果对抠图结果已经满意,可以中途中止流程,完成抠图.

1、登录阿里妈妈创意中心:海棠,申请权限并进入抠图工具页面,点击“长传图片”按钮,上传需要抠图的图片:

图 8 阿里妈妈智能抠图界面

2、算法后台会获取图片,并猜测用户可能需要抠取的目标,并将抠图结果自动返回前端页面展示给用户。

图 9 算法初始化自动抠图提示

3、用户判断自动抠图结果是否满意或者是否为想要抠图目标,如果满意,点击保存按钮,完成抠图过程.

图 10 直接保存初始化自动抠图结果

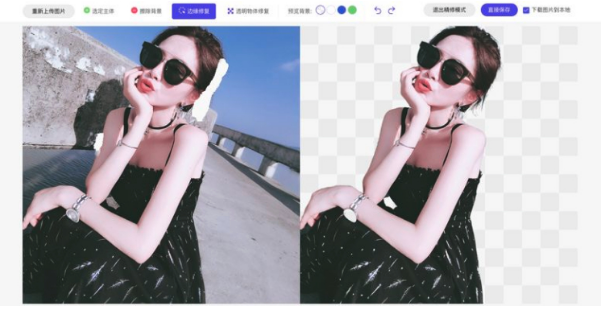

4、如果不满意,进入交互式抠图调整流程. 使用“选定主体”工具原定如下模特主体,算法自动完成抠图,判断结果是否满意. 如果已经满意,保存抠图结果,完成抠图,如果有背景混入,使用“擦除背景”工具去除多余背景,直到满足主体的完整性,如有部分细节缺陷,如部分头发丝缺失或者边缘部分有些许毛刺,可进入“精修模式”调整细节.

图 11 进入交互抠图,使用“选定主体”笔触画前景,算法自动抠图

5、如果对抠图精度要求非常高,对细节和半透明度要求非常细腻,可进入“精修模式”.

图 12 进入精修模式,使用“边缘修复”笔触,处理不理想区域

引用

[1] Quan Chen, Tiezheng Ge, Yanyu Xu, Zhiqiang Zhang, XinXin Yang, KunGai. 2018. Semantic Human Matting. In 2018 ACM Multimedia Conference(MM’18), October 22–26, 2018, Seoul, Republic of Korea. ACM, New York, NY,USA, 9 pages. https://doi.org/10.1145/3240508.3240610

[2]http://webee.technion.ac.il/people/anat.levin/papers/Matting-Levin-Lischinski-Weiss-06.ppt

[3] Wang Jue, and Michael F. Cohen. "Image and video matting: a survey." Foundations and Trends® in Computer Graphics and Vision 3.2 (2008): 97-175.

[4] Ning Xu, Brian Price, Scott Cohen, and Thomas Huang. 2017. Deep image matting.In Computer Vision and Pattern Recognition (CVPR).

[5] Christoph Rhemann, Carsten Rother, Jue Wang, Margrit Gelautz, PushmeetKohli, and Pamela Rott. 2009. A perceptually motivated online benchmark for image matting. In Computer Vision and Pattern Recognition, 2009. CVPR 2009. IEEEConference on. IEEE, 1826–1833.

[6] Anat Levin, Dani Lischinski, and Yair Weiss. 2008. A closed-form solution to natural image matting. IEEE Transactions on Pattern Analysis and Machine Intelligence 30, 2 (2008), 228–242.

[7] Qifeng Chen, Dingzeyu Li, and Chi-Keung Tang. 2013. KNN matting. IEEE transactions on pattern analysis and machine intelligence 35, 9 (2013), 2175–2188.

[8] Donghyeon Cho, Yu-Wing Tai, and Inso Kweon. 2016. Natural image matting using deep convolutional neural networks. In European Conference on Computer Vision. Springer, 626–643.

[9] YagızAksoy, TunçOzanAydın, MarcPollefeys, andETHZürich. 2017. Designing effective inter-pixel information flow for natural image matting. In ComputerVision and Pattern Recognition (CVPR).

4 comments

请问博主,阿里妈妈有没有提供开源这篇paper的开源算法呀

有一些其他人复现的.

谢谢博主提示,在github找到两个实现库 :

:

https://github.com/lizhengwei1992/Semantic_Human_Matting

https://github.com/soyan1999/pytorch_semantic_human_matting

赞!