题目: Look into Person: Self-supervised Structure-sensitive Learning and A New Benchmark for Human Parsing - CVPR 2017

作者: Ke Gong, Xiaodan Liang, Xiaohui Shen, Liang Lin

团队: Sun Yat-sen University, Carnegie Mellon University, Adobe Research,

Code-Caffe

LIP - Project - Home

主要两部分:

[1] - 建立Look into Person(LIP)数据集;

[2] - 提出self-supervised structure-sensitive learning 方法,将人体姿态结果作为人体解析的额外监督(模型训练时不需要人工标注人体关节点).

1. LIP 数据集

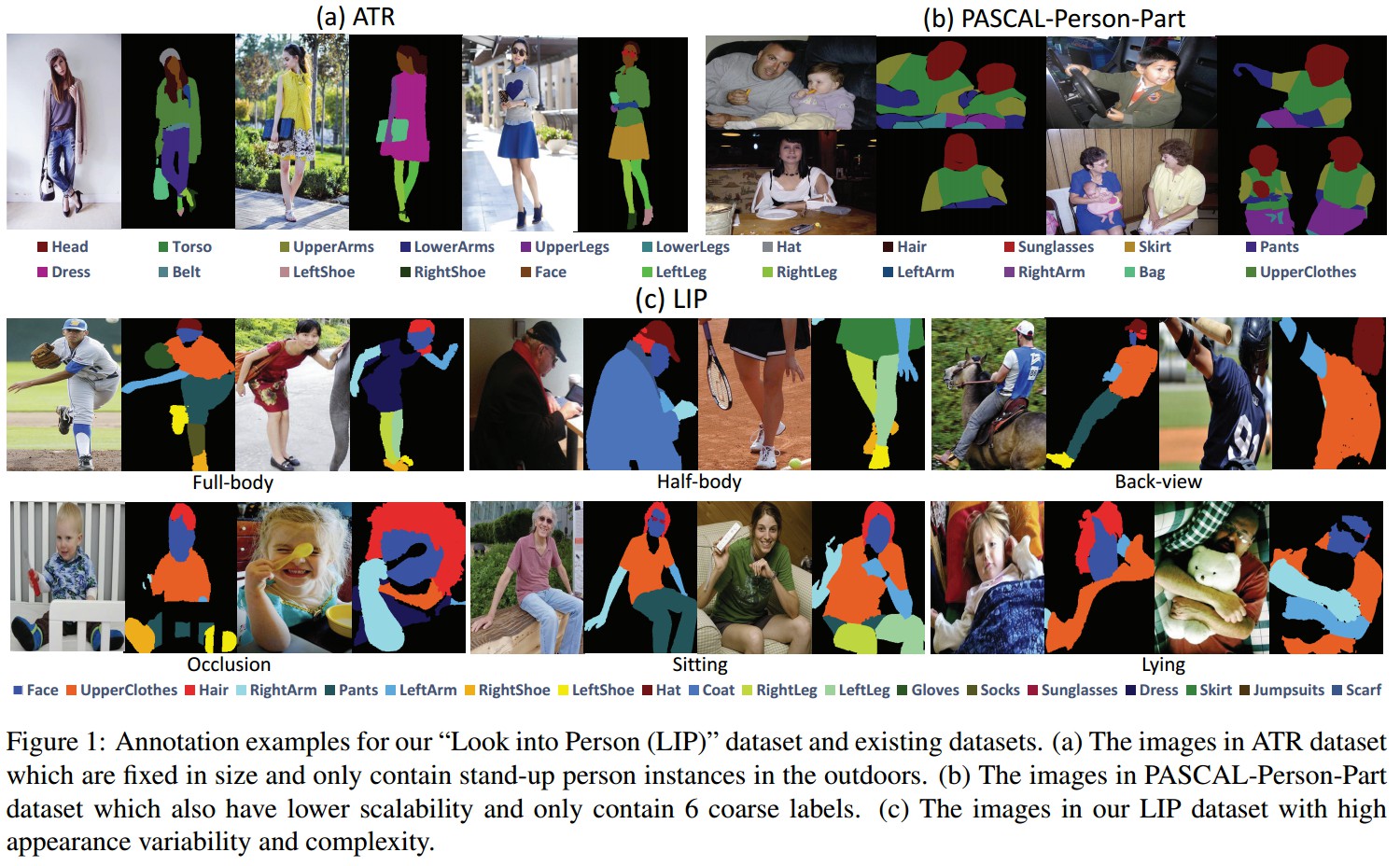

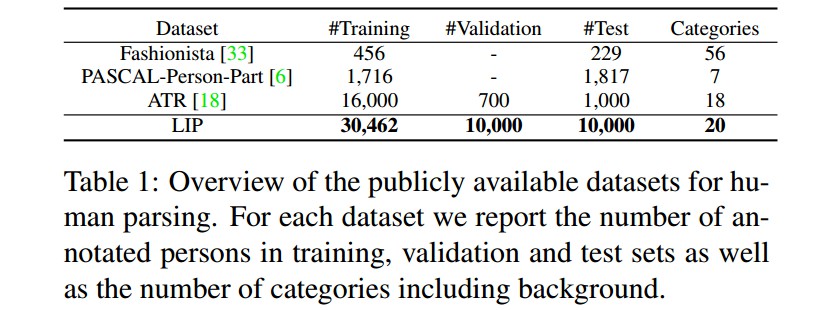

几种不同的标注数据集. (1)ATR 数据集的图片是固定尺寸的(400*600),仅是室外站立的模特,电商图片类适应. (2) PASCAL-Person-Part 数据集的图片只有6种不同的语义标签,与人相关的也较粗糙. (3)LIP数据集多样性和复杂性更高.

LIP数据集:

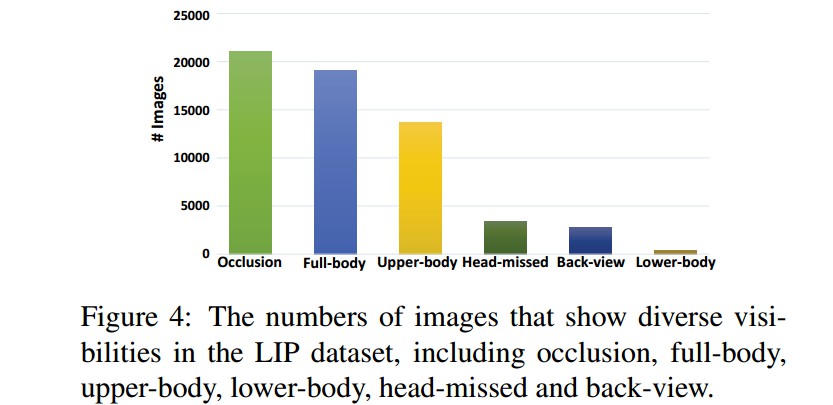

- 共 50462 张图片,19081 张fully-body图片,13672 张upper-body 图片,403 张lower-body 图片,3386 张 head-missed 图片,2788 张 back-view 图片,21028 张 occlutions 图片.

- 304562 张training 图片,10000 张 validation 图片,10000 test 图片.

- 20 类语义标注(1 background + 19 labels)

2. Self-supervised Structure-sensitive Learning

人体解析 —— 像素级语义标注

人体估计 —— 关节点结构预测

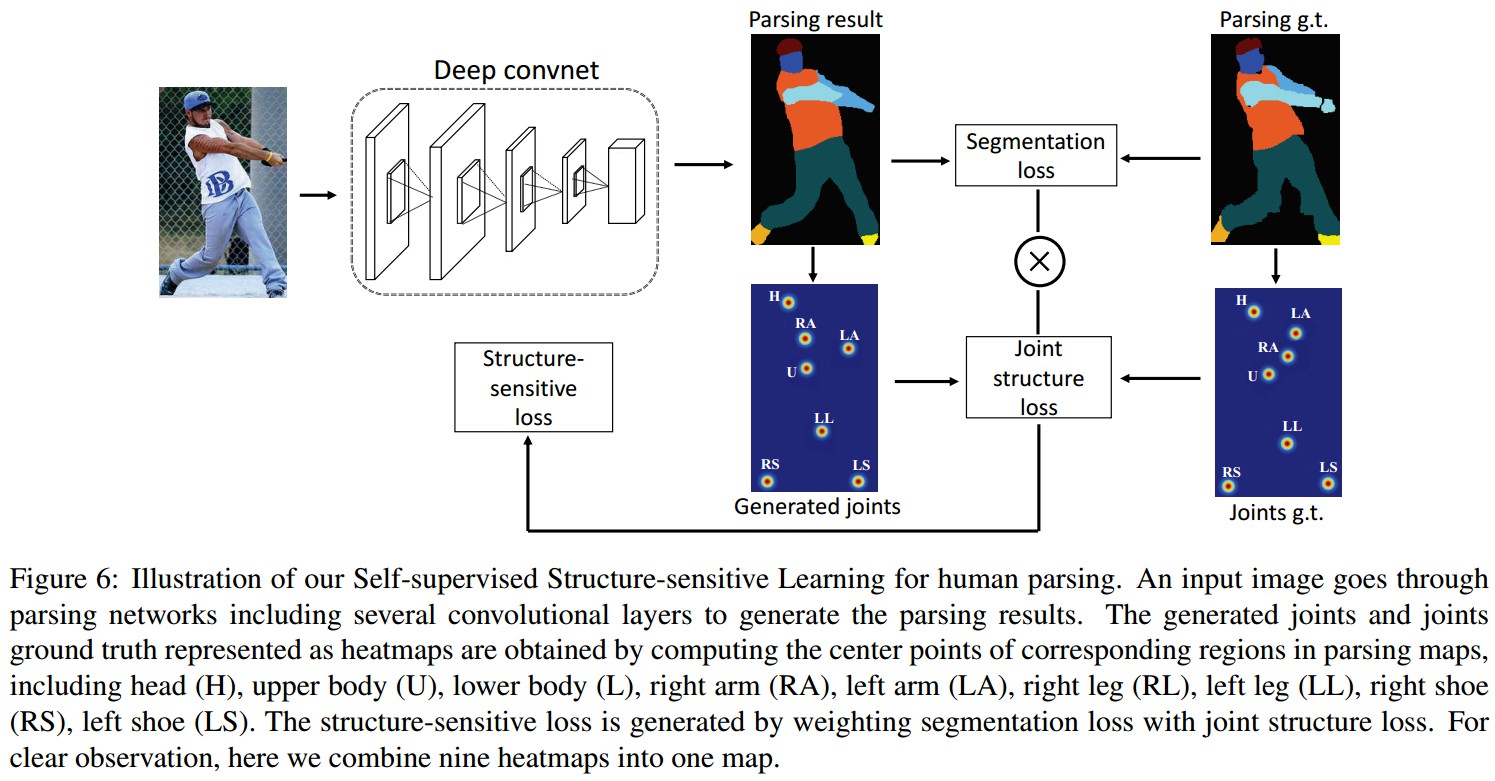

提出了自监督结构敏感损失函数来评价关节点结构引导的人体解析结果的效果.

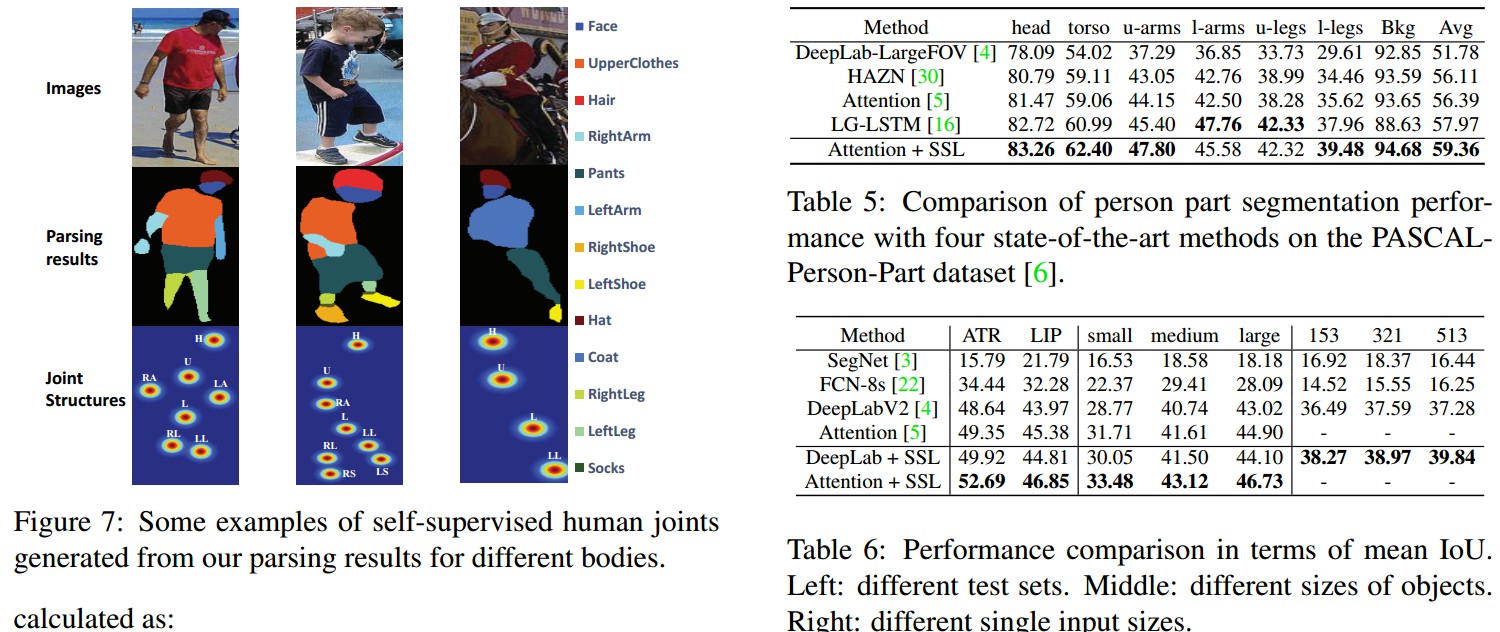

Figure6. 方法图示. 输入图像经过网络卷积层处理生成解析结果. 通过计算人体解析图的对应区域的中心点,来得到的关节点和关节点的groundtruth的 heatmaps,9 个关节点分别为 head (H), upper body (U), lower body (L), right arm (RA), left arm (LA), right leg (RL), left leg (LL), right shoe(RS), left shoe (LS). 对 segmentation loss 和 joint structure loss的加权计算来得到 structure-sensitive loss.

给定图片 ${ I }$,

定义关节点组合 ${ C_I^P = {c_i^p|i \in [1, N]} }$,其中 ${ c_i^p }$ 是根据人体解析图计算得到的第 $i$ 个关节点的 heatmap.

定义关节点组合 ${ C_I^{GT} = {c_i^{gt}|i \in [1, N]} }$,是根据真实的groundtruth人体解析图计算得到的对应关节点 heatmap.

这里 N 为根据输入图片${ I }$ 中人体来决定的关节点数. full-body 图片时,N=9. 如果关节点不存在,则设为0.

Joint structure loss:

${ L_{Joint} = \frac{1}{2N} \sum_{i=1}^{N} ||c_i^p- c_i^{gt}||_2^2 }$

Final structure-sensitive loss

${ L_{Structure} = L_{Joint} \cdot L_{Parsing} }$

${ L_{Parsing} }$ 是语义分割用的逐像素 softmax loss(pixel-wise softmax loss).

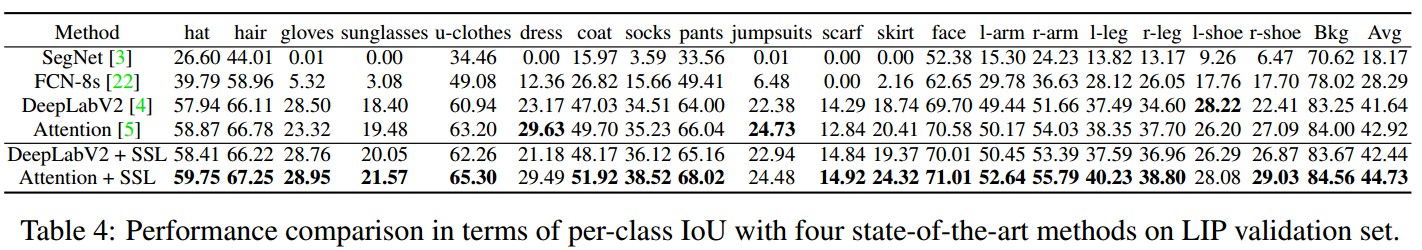

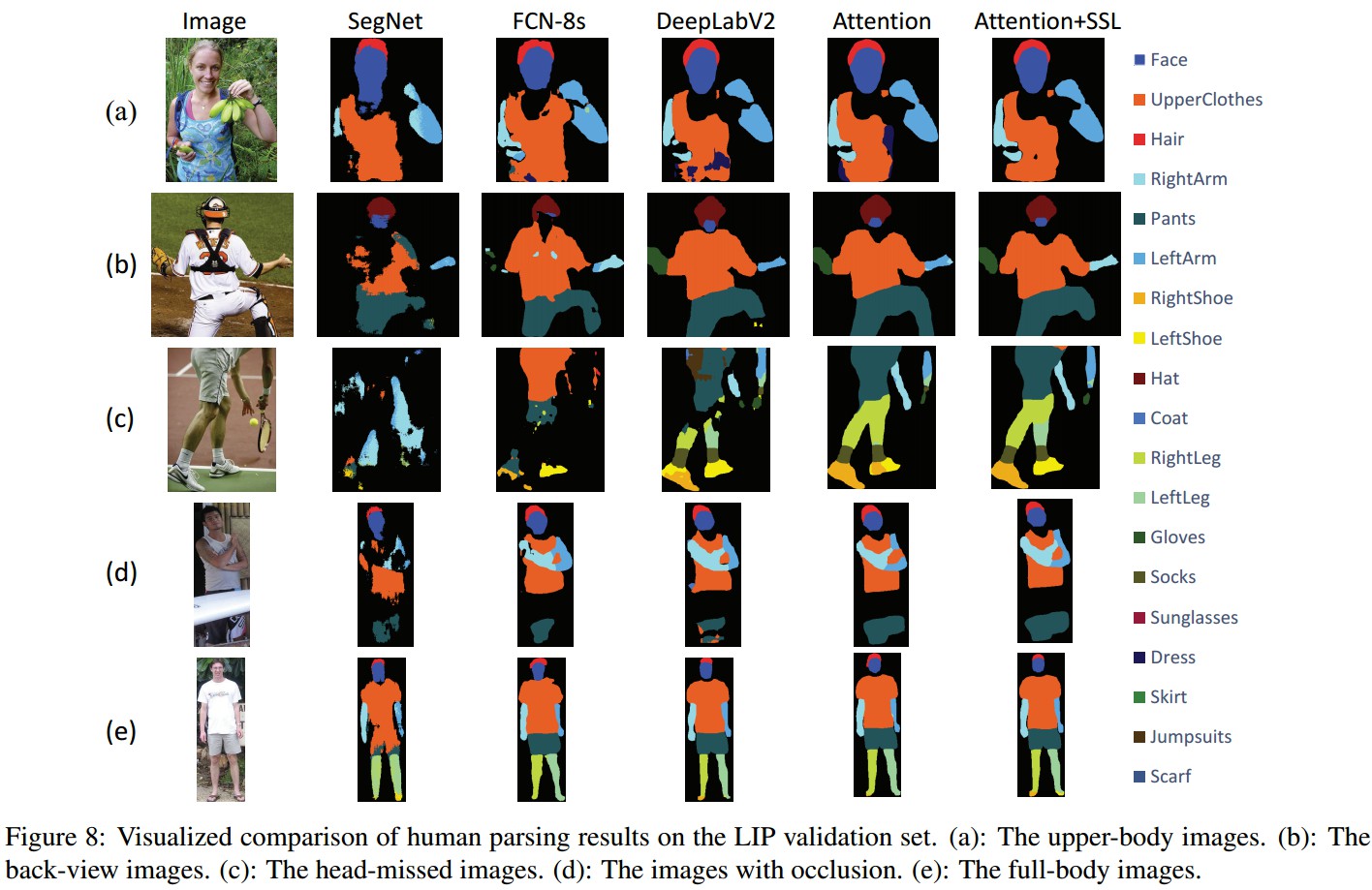

3. Results