图像检索评价指标

1. Precision & Recall & F-Score

1.1. Precision

Precision - 查准率;准确率.

$$ \text{Precision} = \frac{检索到的相似图片个数}{检索到的全部图片总数} = \frac{预测为正样本的图片个数}{所有被预测为正样本的图片总数} $$

1.2. Recall

Recall - 查全率;召回率.

$$ \text{Recall} = \frac{检索到的相似图片个数}{数据集里全部相似图片总数} = \frac{预测为正样本的图片个数}{所有正样本的图片总数} $$

查全率与查准率互相影响,最理想的是二值都高. 但一般情况下是,{查全率高,查准率低},{查全率高,查准率低}.

保证查全率的情况下,提升查准率 - 搜索任务等;

保证查准率的情况下,提升查全率 - 疾病监控、反垃圾邮件、地震预测、金融欺诈等.

1.3. F-Score

F-Score - 对于查全率与查准率都有较高要求.

$$ \text{F-Score} = (1 + \beta^2)\frac{\text{Precision} \cdot \text{Recall}}{\beta^2 \cdot (\text{Precision} + \text{Recall})} $$

调节 $\beta$ 值可以控制 Precision 和 Recall 的权重.

$\beta < 1$,查准率更重要;

$\beta > 1$ ,查全率更重要;

$\beta = 1$,称为 F1-Score或 F1,$\text{F1} = \frac{2 * \text{Precision} \cdot \text{Recall}}{\text{Precision} + \text{Recall}}$

注:分类问题中的 $准确率(accuracy) = \frac{正确分类的样本数}{样本总数}$

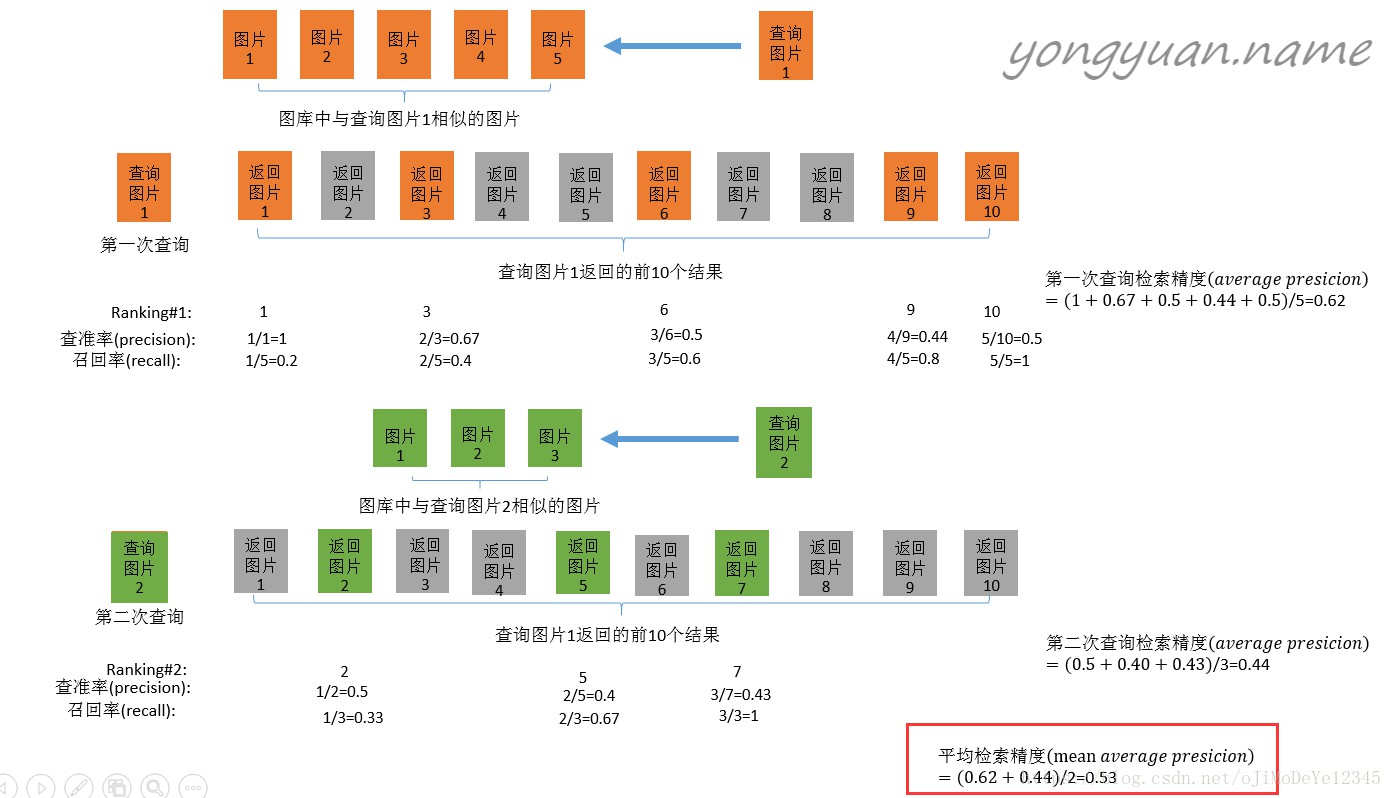

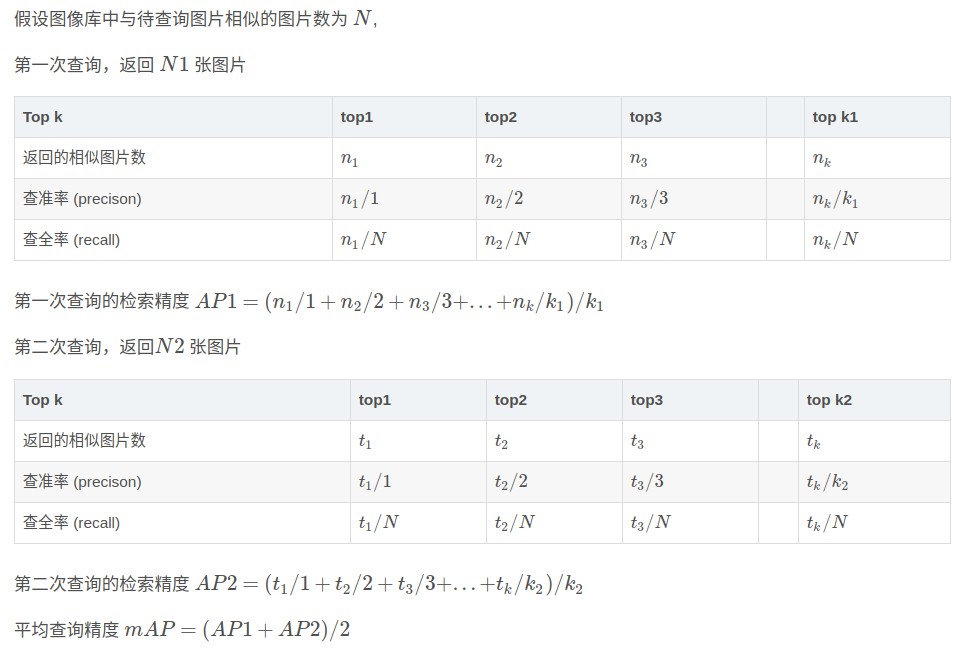

2. AP & mAP

图像检索精度(average precision, AP)

图像平均检索精度(mean average precision, mAP)

3. 例示

http://yongyuan.name/blog/evaluation-of-information-retrieval.html

一个很好的图片概括: