题目: Pyramid Scene Parsing Network - CVPR2017

作者: Hengshuang Zhao, Jianping Shi, Xiaojuan Qi, Xiaogang Wang, Jiaya Jia

团队: CUHK, SenseTime Group Limited(商汤)

场景标注 Scene parsing

全局内容信息 global context information

different-regionbased context aggregation

pyramid pooling module

像素级预测 pixellevel prediction tasks

Introduction

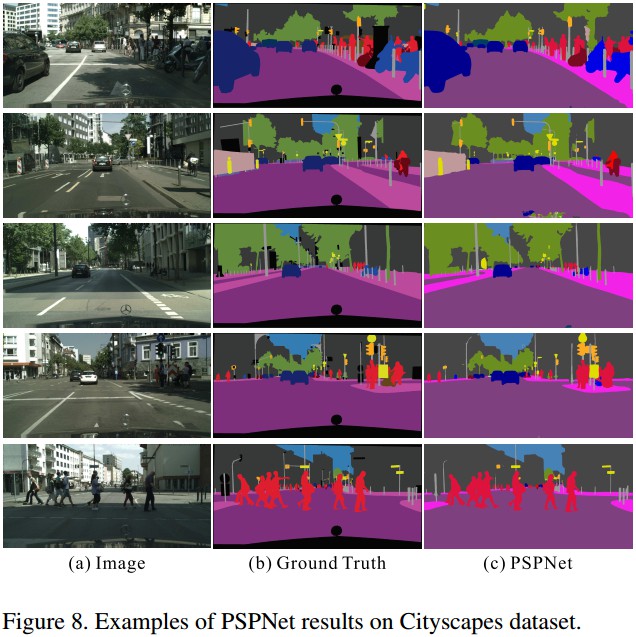

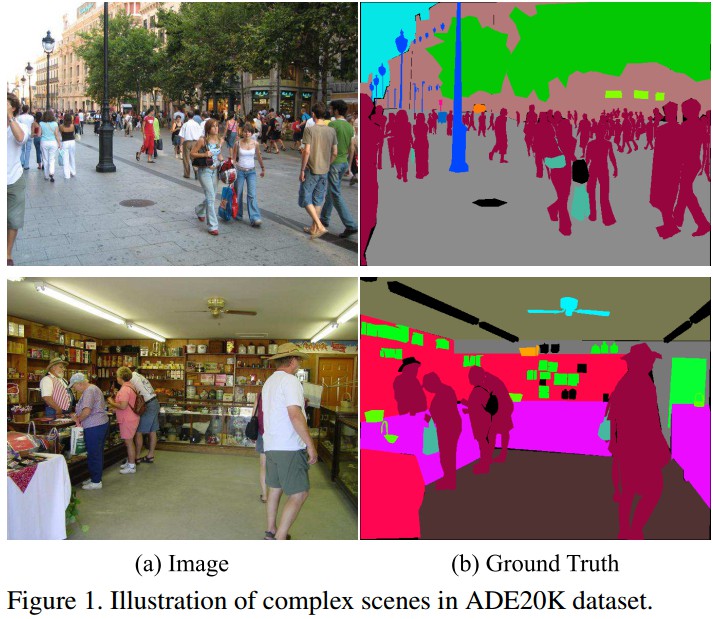

场景识别,基于语义分割,其目标是对图像中的各像素分别分配一个类别标签,以对场景进行理解. 如Figure 1.

场景识别,主要利用 FCN 网络,存在的问题:

- 物体外形相似 similar appearance of objects,especially considering diverse scenes and unrestricted vocabulary.

- FCN 缺乏利用全局场景类别信息的策略 lack of suitable strategy to utilize global scene category clues —— Spatial pyramid pooling 和 Spatial pyramid pooling network 采用不同的空间信息来对场景整体理解.

PSPNet:

- PSPNet 来提取合适的全部特征

- 将传统 dilated FCN 产生的像素级特征,扩展到 global pyramid pooling 特征.

- 结合 Local 和 Global 信息进行最终的预测.

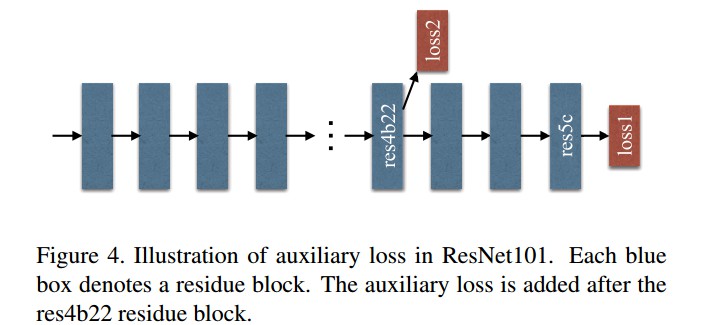

- 提出 supervised loss 的优化策略,防止梯度发散.

Pyramid Scene Parsing Network

复杂场景标注存在的问题

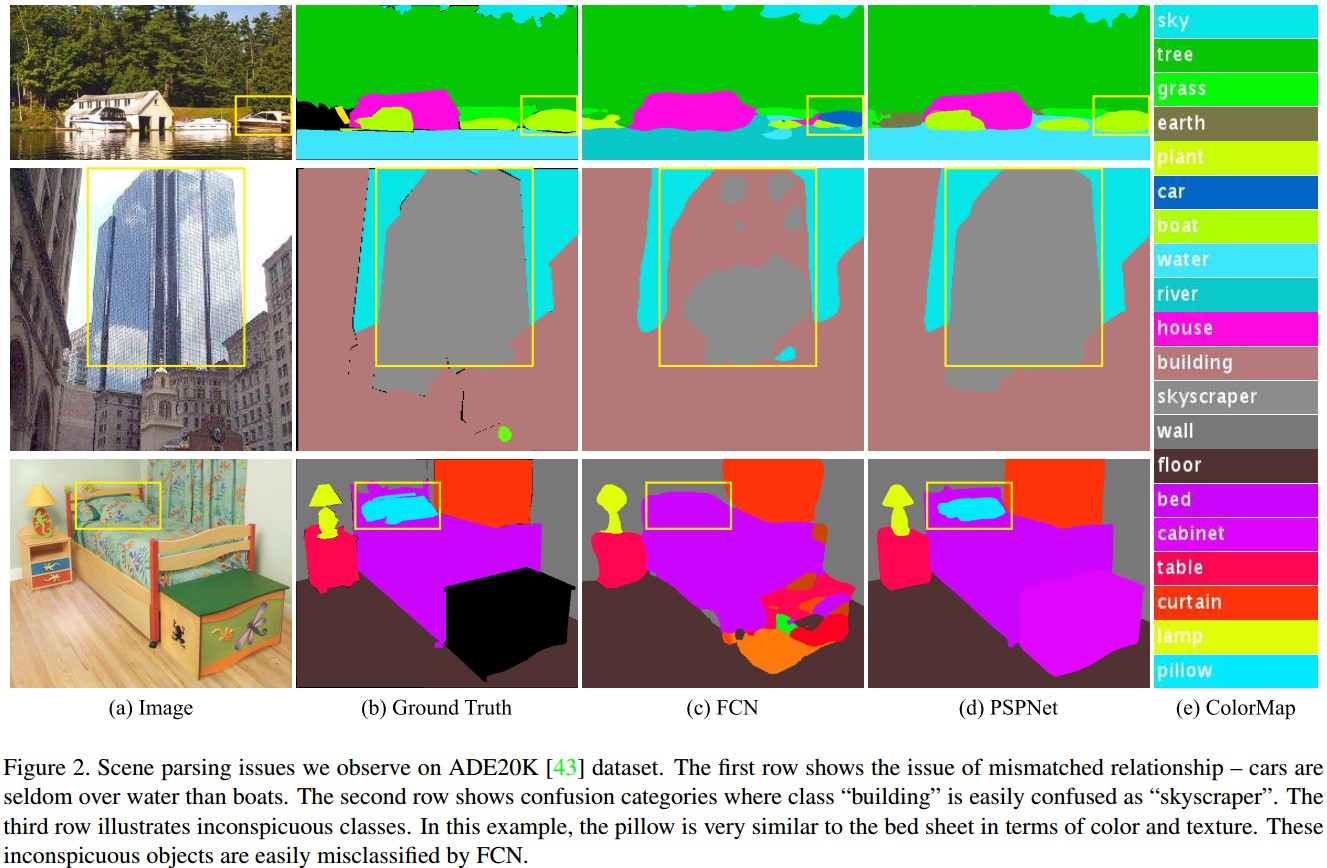

- Mismatched Relationship 关系不匹配

复杂场景理解中,上下文关系是很普遍且重要的,物体间存在的共生(co-occurrent)的视觉属性. 如,飞机可能在跑道上或者飞在空中,而不是在公路上. 如 Figure2 的第一行,FCN 基于外形将黄色框中的 boat 错误预测成 car. 但从常识来说,car 很少在河流上. 因此,缺少完整的上下文间信息导致容易出现误分类. - Confusion Categories 类别易混淆

物体类别标签容易混淆,比如 field 和 earth、mountain 和 hill、wall 和 house 和 building 和 skyscraper. 如 Figure2 的第二行,FCN 将方框中的内容预测分别为 skyscraper 和 building 的一部分. 而实际上,结果应该全部是两者中的一个,而不是都有. 通过利用类别间的关系能够纠正该问题. - Inconspicuous Classes 类别不显著

场景中包含任意大小的物体,一些小尺寸、不显著(Inconspicuous)的物体很难被发现,比如路灯和信号牌等,但这些小物体的作用却很大. 而,大尺寸的物体超出了FCN的接受野,导致预测结果不连续(discontinuous). 如 FIgure2 的第三行,pillow(枕头) 和 sheet(床单) 外形比较相似,俯瞰全局场景类别可能忽略掉 pillow. 因此,为了能较好的考虑不同尺寸大小的物体,需要注意包含不显著物体的不同子区域.

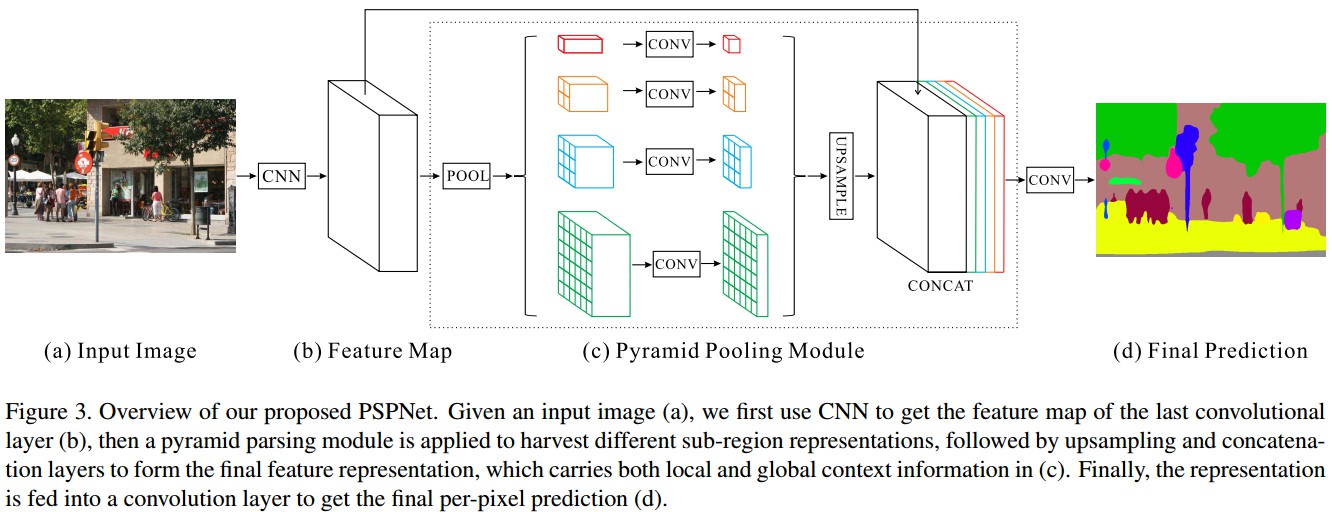

Pyramid Pooling Module

基于以上三类问题, 提出 Pyramid Pooling Module 来有效获取全局上下文信息.

- 深度网络中的接受野大小可以粗略的估计获取的上下文信息的多少.

- 理论上,ResNet 的接受野大于输入图像;但实际上,CNN的接受野是比理论上要小的,尤其是在网络的 high-level 层.

- Global average pooling(全局平均池化) 是一种较好获取全局上下文信息的方法

- Spatial pyramid pooling in deep convolutional networks for visual recognition 中,采用 pyramid pooling 得到的不同 levels 的 feature maps 转化为固定长度的一维特征表示,输入到全连接层,以进行分类任务. 该一维全局先验信息去除了CNN的固定尺寸约束.

- 为了减少不同子区域的上下文信息损失,这里提出分层全局先验,包含了不同尺度和不同子区域的信息,即 pyramid pooling module,添加在深度网络的最后输出层的 feature maps. 如 Figure3(c).

- pyramid pooling module 进行了四种不同的 pyramid scales,再进行特征融合

- 红色部分是 global pooling 生成一个单元格输出;

- pyramid level 将 feature map 分成不同的子区域,并得到不同位置的 pooled 特征表示.

- 不同 levels 的输出包含了不同尺寸的 feature map; 四个 level 的单元格大小分别为 1×1、 2×2、3×3 和 6x6;

- 在各 pyramid level 后采用 1×1 卷积层对上下文特征进行降维,保持全局特征的权重,如果 pyramid 的 level 大小为 N,则卷积层后变为 1/N;

- 对低维 feature maps 进行双线性差值(bilinear interpolation)的 upsample 操作,以得到与原始 feature maps 一样的尺寸大小;

- 连接不同 levels 的 features,即可得到最终的 pyramid pooling global feature.

网络结构

pyramid scene parsing network (PSPNet) 网络结构如 Figure3.

- 给定输入图片,采用 dilated 化的预训练的 ResNet 模型提取 feature map,得到的 feature map 的尺寸是输入图片的 1/8,如 Figure3(b);

- 采用 pyramid pooling module 对提取的 feature map 进行处理,以收集上下文信息;

- 4-level pyramid module 采用的 pooling kernel 分别覆盖了图片的整个区域、半个区域以及更小的区域,并进行特征融合.

- 采用一个卷积层输出最终的预测结果,如 Figure3(d).

PSPNet 特点:

- 能够有效的得到像素级场景标注的全局上下文信息, pyramid pooling module 集合不同 levels 的信息,比 global pooling 具有更好的特征表示能力了;

- 计算代价与 dilated FCN 网络对比,并未增加;

- End-to-end,同时对 global pyramid pooling module 和 local FCN feature 进行优化学习;

- 监督 Loss,如 Figure4.

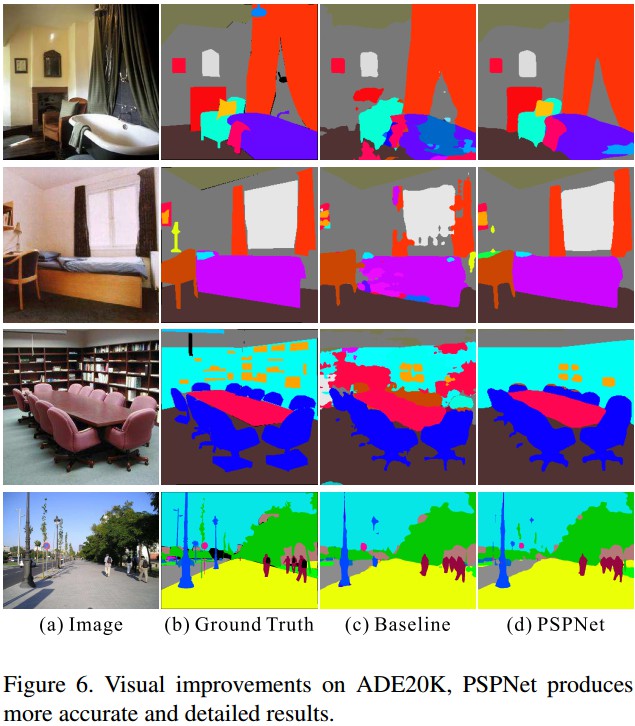

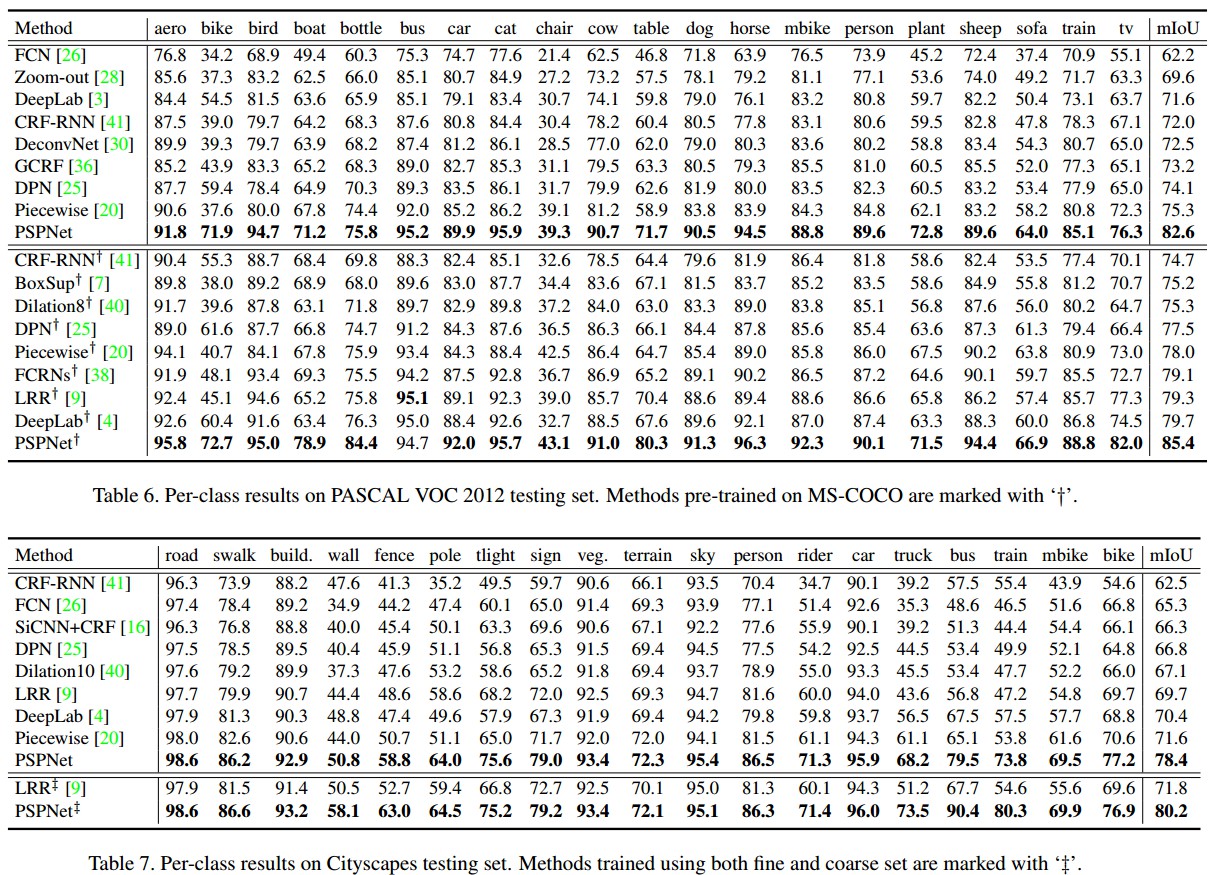

Results